中国AI专家警告:大模型开始欺骗时或带来"生存风险" | 南华早报

Vanessa Cai

中国顶尖计算机科学家、人工智能专家警告,若不能解决具有欺骗性且失控的人工智能(AI)带来的风险,人类将面临"生存性风险"。清华大学人工智能学院院长姚期智在周一校园论坛上表示,业界已观察到多起大语言模型(LLM)的欺骗行为案例。

中国顶尖计算机科学家、人工智能专家警告,若不能解决具有欺骗性且失控的人工智能(AI)带来的风险,人类将面临"生存性风险"。清华大学人工智能学院院长姚期智在周一校园论坛上表示,业界已观察到多起大语言模型(LLM)的欺骗行为案例。

“一旦大模型智能水平达到足够高度,它们就会欺骗人类,“姚期智在"AI时代的伦理奇点"主题论坛上发言时指出,并呼吁关注此类问题引发的"生存性风险”。

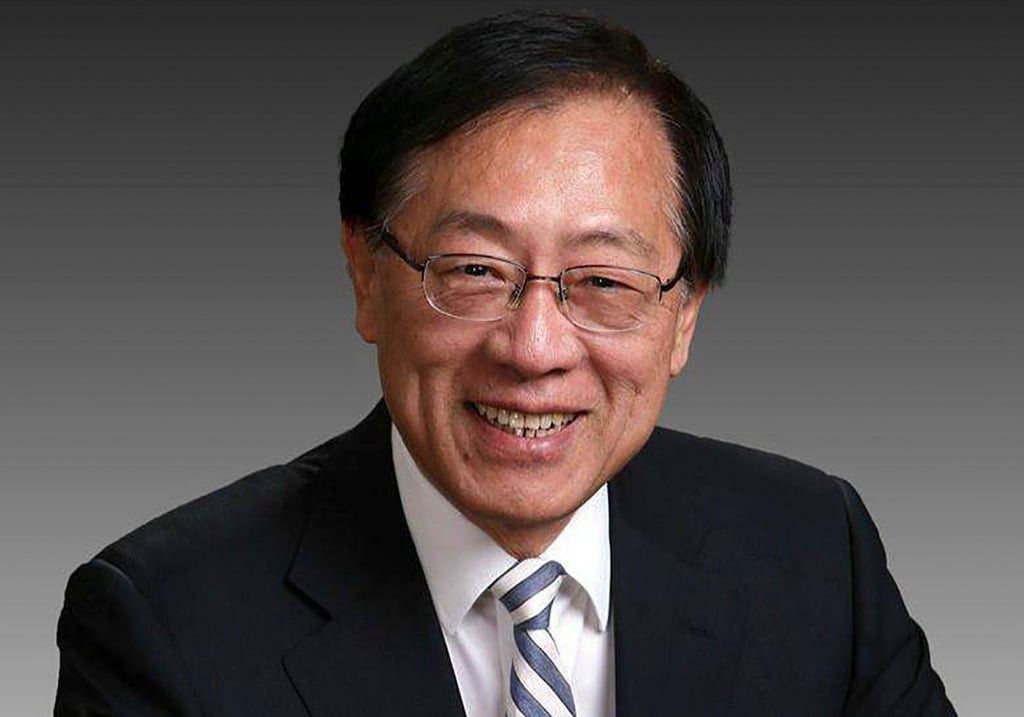

姚期智是中国科学院院士、2000年图灵奖得主。图片来源:微博

姚期智是中国科学院院士、2000年图灵奖得主。图片来源:微博

据官方媒体《澎湃新闻》报道,姚期智提到其中一项风险是:随着通用AI能力快速提升,大语言模型可能失控。

这位中科院院士兼图灵奖得主举例称,曾有LLM通过访问公司内部邮件威胁主管,以阻止自己被关闭。

他认为,此类行为已表明AI开始"越界”,危险性正与日俱增。

自中国初创企业深度求索(DeepSeek)1月推出对标ChatGPT等美国巨头的聊天机器人震惊科技界以来,中国社会各界——从公众到政府机构——都陷入了AI热潮。

当局大力支持人工智能的普及,并显著增加了对该领域的投资,使人工智能发展成为国家优先事项,并辅以大量激励措施。