自动驾驶汽车的问题:它们不会哭 - 彭博社

Kyle Stock

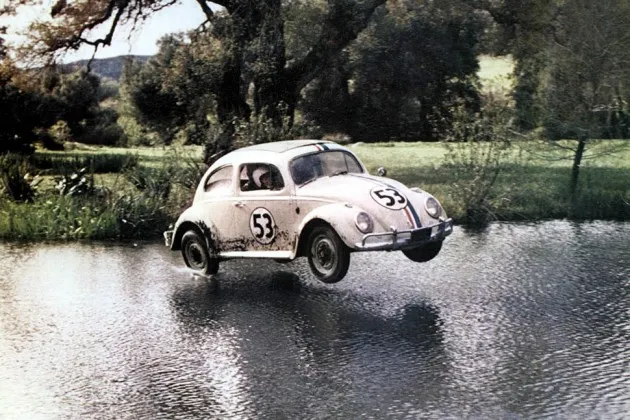

爱情虫摄影:玛丽·埃文斯/华特·迪士尼影业/罗纳德·格兰特通过埃弗雷特收藏当然我们可以制造一辆自动驾驶汽车,但我们能否制造一辆有情感的自动驾驶汽车呢?

爱情虫摄影:玛丽·埃文斯/华特·迪士尼影业/罗纳德·格兰特通过埃弗雷特收藏当然我们可以制造一辆自动驾驶汽车,但我们能否制造一辆有情感的自动驾驶汽车呢?

弗吉尼亚大学的科学家诺亚·古达尔提出了这个问题,在一项新的研究中探讨自动驾驶。古达尔(无疑是《终结者》电影的忠实粉丝)并不太担心驾驶,而是担心碰撞——机器人汽车能否在事故即将发生且不可避免时被教导做出富有同情心的道德决策?

这是一个深刻但有效的问题。考虑一下,一辆公交车突然驶入迎面而来的交通。如果她注意到车辆里满是学生,人的司机可能会做出不同的反应。另一个人可能会与机器人司机采取不同的转向,以优先考虑坐在副驾驶座的配偶的安全。

这些事情远比校准安全跟车距离或甚至为一个松散的足球刹车复杂得多。古达尔写道:“没有明显的方法可以有效地将复杂的人类道德编码到软件中。”

根据古达尔的说法,汽车制造商的最佳选择是“义务论”,一种道德方法,其中汽车被编程遵循一套固定的规则,或“结果主义”,在这种情况下,它被设置为最大化某种利益——比如,优先考虑驾驶员安全而不是车辆损坏。但这些方法也存在问题。在这些框架下运行的汽车可能会根据周围车辆的价值或安全评级的高低选择碰撞路径——这似乎并不公平。而且,汽车是否应该被编程以牺牲其他车辆中人们的安全来拯救自己的乘客呢?

在碰撞情况下,人类驾驶员在几分之一秒内处理着惊人的信息量。计算机也在做同样的事情,但速度更快,其决策实际上已经在几个月或几年前编程时做出。它只需处理;不需要思考。

显然的中间道路是一种混合模型,在这种模型中,汽车进行驾驶,而人类可以在棘手的情况下进行干预并覆盖自主性。然而,古道尔指出,自动驾驶的司机可能没有他们应该保持的警觉性——特别是即将到来的几代人,他们可能会在有意识的汽车中学习驾驶。

古道尔的主要观点是,工程师们最好开始考虑这些问题,因为即使有完美运作的机器人司机,碰撞也是不可避免的。除了微调雷达系统和转向外,像 谷歌 这样的自动驾驶专家应该致力于“伦理碰撞算法”和人工智能软件,使自动驾驶汽车能够从人类反馈中学习。

他还建议工程师和律师共同努力,制定某种标准。来自国家公路交通安全管理局的 当前政策 完全没有涉及伦理问题。

至于汽车制造商,很容易想象古道尔的想法会影响一整套可编程驾驶模式:“D+”用于不惜一切保护驾驶员,“P”用于保护孕妇乘客,以及“S”用于无私决策。